2023年中国智算中心行业技术架构分析 智算中心采用领先AI计算架构发布时间: 2024-02-25 来源:智能计算领域

原标题:2023年中国智算中心行业技术架构分析 智算中心采用领先AI计算架构

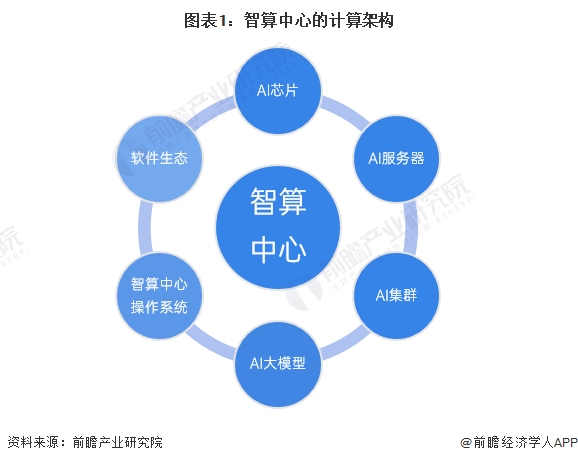

《智能计算中心创新发展指南》指出,智算中心的发展基于最新人工智能理论和领先的AI计算架构,算力技术与算法模型是其中的关键核心技术,算力技术以AI芯片、AI服务器、AI集群为载体,而当前的算法模型发展的新趋势以AI大模型为代表。在此基础上,通过智算中心操作系统作为智算中心的“神经中枢”对算力资源池进行高效管理和智能调度,使智算中心更好地对外提供算力、数据和算法等服务,支撑各类智慧应用场景落地。而软件生态则是智算中心“好用、用好”的关键支撑。

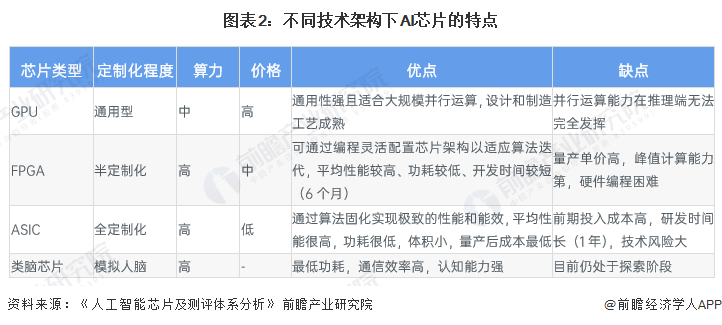

基于AI芯片的加速计算是当前智能计算的主流模式。AI芯片通过和AI算法的协同设计来满足AI计算对算力的超高需求。当前主流的AI加速计算主要是采用CPU系统搭载GPU、FPGA、ASIC等异构加速芯片。

近年来,国产AI加速芯片厂商持续发力,在该领域取得了快速进展,相关这类的产品陆续发布,覆盖了AI推理和AI训练需求,其中既有基于通用GPU架构的芯片,也有基于ASIC架构的芯片,另外也出现了类脑架构芯片,总体上呈现出多元化的发展趋势。

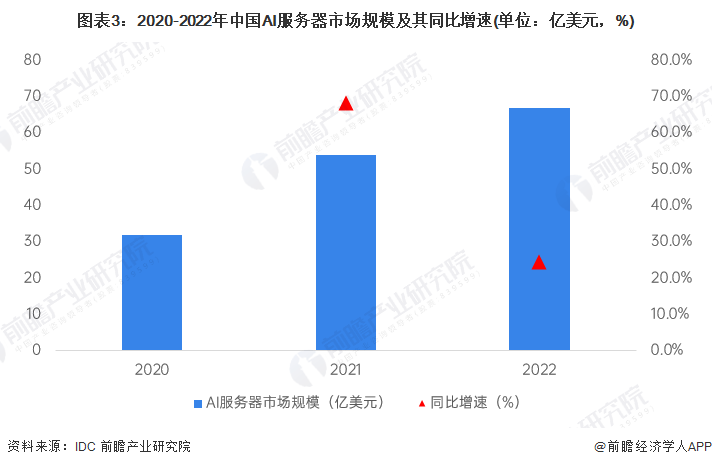

根据《智能计算中心创新发展指南》,AI服务器是智算中心建设中投入比重最大、最为关键的设备。AI服务器是智算中心的算力机组。当前AI服务器主要是采用CPU+AI加速芯片的异构架构,通过集成多颗AI加速芯片实现超高计算性能。目前业界以NVLink和OAM两种高速互联架构为主,其中NVLink是NVIDIA开发并推出的一种私有通信协议,其采用点对点结构、串列传输,能够达到数百GB/s的P2P互联带宽,极大地提升了模型并行训练的效率和性能。

根据IDC发布的《中国半年度加速计算市场(2022下半年)跟踪》报告,2022年中国AI服务器市场规模达到67亿美元,同比增长24%。其中GPU服务器依然是主导地位,占据89%的市场占有率,达到60亿美元。同时NPU、ASIC和FPGA等非GPU加速服务器以同比12%的增速占有了11%的市场占有率,达到7亿美元。

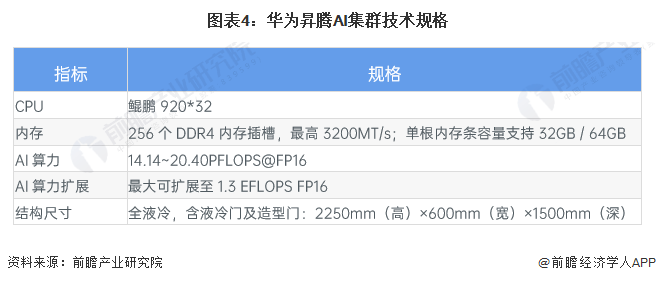

大模型参数量和训练数据复杂性迅速增加,对智算系统提出大规模算力扩展需求。通过最大限度地考虑大模型分布式训练对于计算、网络和存储的需求特点,可以设计构建高性能可扩展、高速互联、存算平衡的AI集群来满足尖端的智能计算需求。

2023年7月,华为宣布昇腾AI集群全面升级,推出首个万卡AI集群,拥有更快的训练速度和30天以上的稳定训练周期,十倍领先业界。目前,昇腾AI集群已支撑全国25个城市的AI计算中心建设,其中7个城市公共算力平台入选首批国家“新一代人工智能公共算力开放创新平台”。

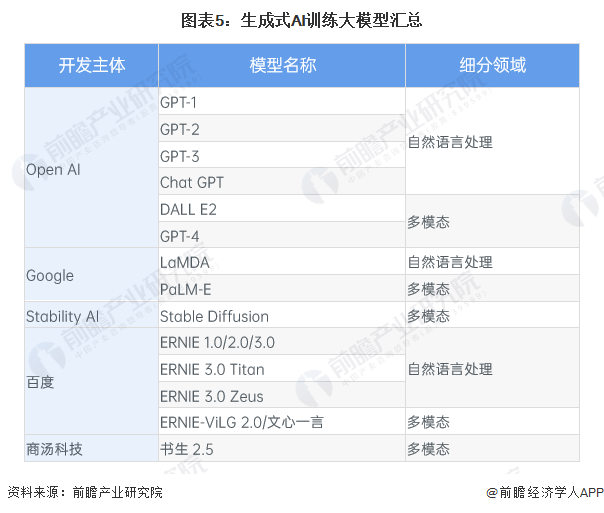

超大规模智能模型,简称大模型,是近年兴起的一种新的人工智能计算范式。和传统AI模型相比,大模型的训练使用了更多的数据,具有更好的泛化性,能应用到更广泛的下游任务中。按照应用场景划分,AI大模型最重要的包含语言大模型、视觉大模型和多模态大模型等。业界典型的自然语言大模型有GPT-3、源、悟道和文心等。视觉大模型也已大范围的应用于无人驾驶、智能安防、医学影像等领域。基于多模态大模型的以文生图技术也快速地发展,AI内容生成(AI Generated Content,AIGC)已成为下一个AI发展的重点领域。

同时前瞻产业研究院还提供、、、、、、、、、咨询等解决方案。在招股说明书、公司年度报告等任何公开信息公开披露中引用本篇文章的主要内容,需要获取前瞻产业研究院的正规授权。

更多深度行业分析尽在【前瞻经济学人APP】,还可以与500+经济学家/资深行业研究员交流互动。返回搜狐,查看更加多